Activation function?

입력신호를 출력신호로 변환해주는 함수

선형 분류의 한계로 non-linear 한 결과는 얻을 수 없었으나 활성함수로 선형 시스템을 비선형 분류기로 만들 수 있게 됨

입력 받은 신호를 얼마나 출력할지 결정하고 네트워크에 층을 쌓아 비선형성을 표현할 수 있도록 해준다.

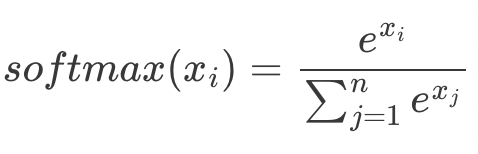

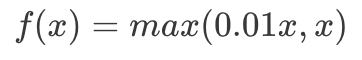

| 수식 | 모양 | 범위, 평균 | 장점/단점 | |

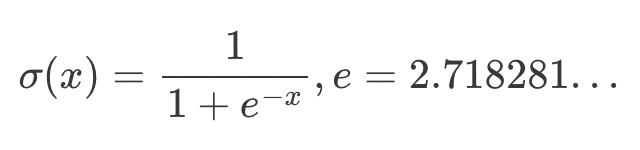

| sigmoid |  |

[0, 1], 0.5 | vanishing gradient no-zero centered |

|

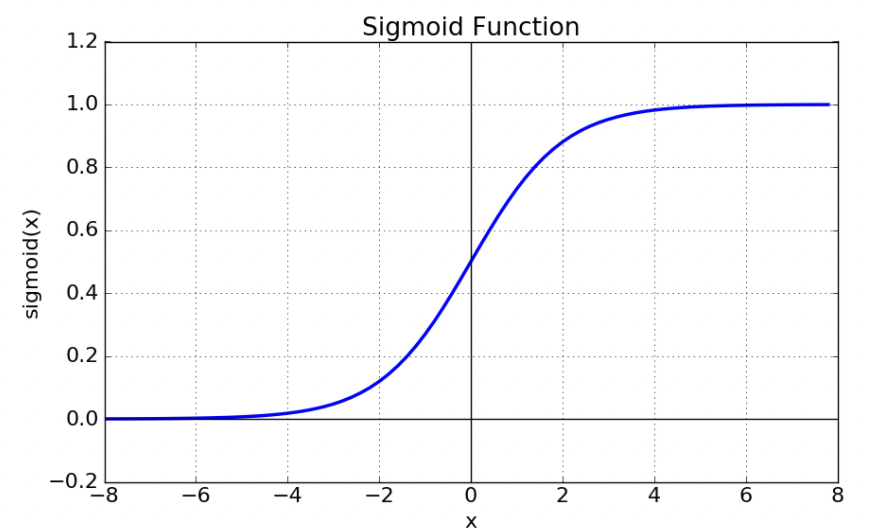

| tanh 하이퍼볼릭 탄젠트 |  |

|

[-1, 1], 0 | zero-centered vanishing gradient |

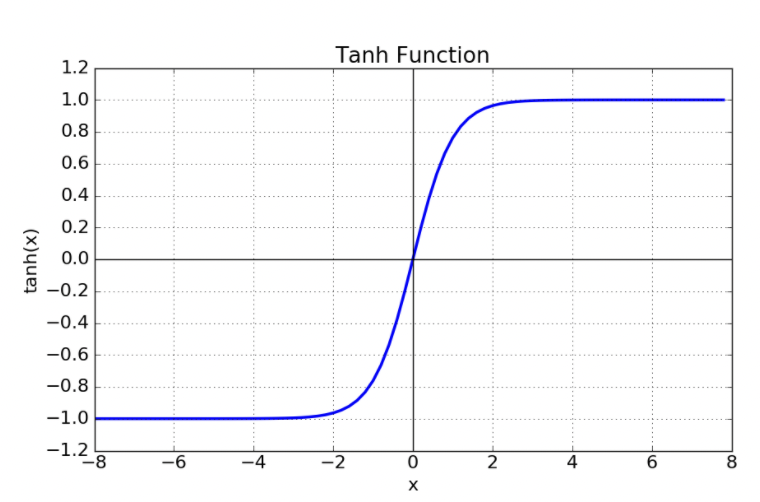

| Softmax |  |

|||

| MaxOut |  |

ReLU 장점 가짐, Dying ReLU 해결 전체 파라미터 2배 증가 |

||

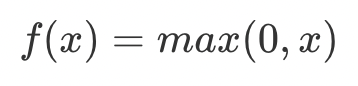

| ReLU |  |

|

vanishing gradient 해결, Sparsity Dying ReLU(입력값이 음수인 경우 기울기가 0이 되어 가중치 업데이트가 안될 수 있음), no-zero centered |

|

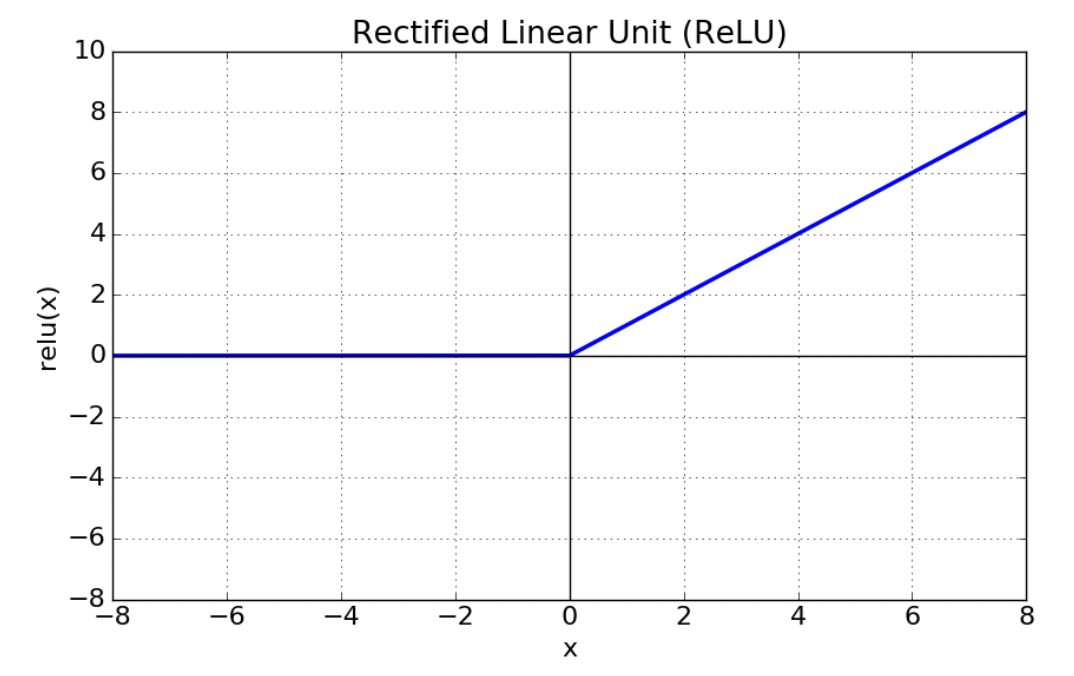

| LeakyReLU |  |

|

Dying ReLU 해결 | |

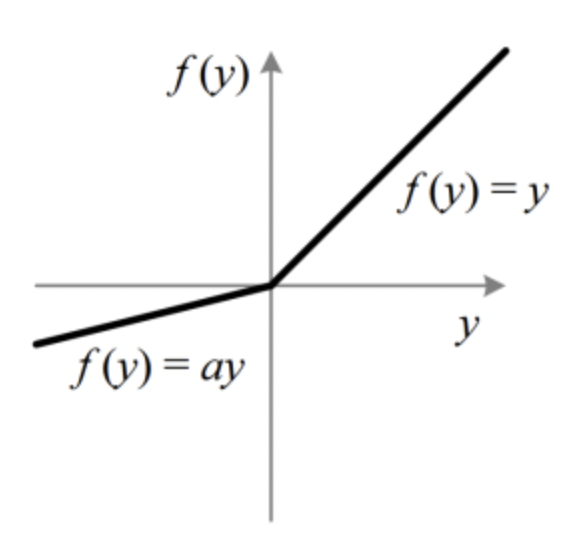

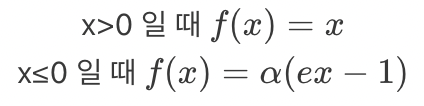

| PReLU |  |

|

||

| ELU |  |

|

Dying ReLU 해결 exp 미분값 계산 필요 |

|

References

https://ganghee-lee.tistory.com/32

활성화 함수(activation function)종류 및 정리

<활성화 함수 종류> <시그모이드(Sigmoid)> 수식 : output값을 0에서 1사이로 만들어준다. 데이터의 평균은 0.5를 갖게된다. 위 그림에서 시그모이드 함수의 기울기를 보면 알 수 있듯이 input값이 어느

ganghee-lee.tistory.com

https://heeya-stupidbutstudying.tistory.com/38

[ML] 활성화 함수(Activation Function) 종류 정리

신경망에서는 노드에 들어오는 값들에 대해 곧바로 다음 레이어로 전달하지 않고 활성화 함수를 통과시킨 후 전달한다. 활성화 함수(activation function)는 입력 신호의 총합을 출력 신호로 변환하

heeya-stupidbutstudying.tistory.com

https://seongkyun.github.io/study/2019/05/01/activations/

Activation function 종류 및 특징 · Seongkyun Han's blog

Leaky ReLU와 비슷하나, PReLU는 $\alpha$ 파라미터를 추가하여 $x<0$ 에서의 기울기를 학습시킬 수 있게 함

seongkyun.github.io

https://seongkyun.github.io/study/2019/05/01/activations/

Activation function 종류 및 특징 · Seongkyun Han's blog

Leaky ReLU와 비슷하나, PReLU는 $\alpha$ 파라미터를 추가하여 $x<0$ 에서의 기울기를 학습시킬 수 있게 함

seongkyun.github.io

'공부 > 복기' 카테고리의 다른 글

| Vector (0) | 2022.02.22 |

|---|---|

| Lvalue 와 Rvalue (0) | 2022.02.22 |

| 평균값과 중앙값 (0) | 2022.02.22 |

| map vs unordered_map (0) | 2022.02.22 |